La pollution atmosphérique décryptée par la donnée

Publié le dans seminar-past

Séminaire du Mastère Spécialisé Big Data de Télécom ParisTech du jeudi 22 octobre 2015

David Lissmyr, co-fondateur de la start-up Plume Labs, est venu expliquer aux étudiants comment les données issues de nombreuses sources (météo, activités humaines, stations de surveillance…) peuvent être mises à profit pour modéliser les épisodes de pollution et anticiper des pics.

Certaines estimations annoncent que 7 millions de personnes meurent chaque année à cause de la mauvaise qualité de l’air qu’elles respirent. Les particules fines seraient responsables de la perte de 6 mois d’espérance de vie. Le Sénat français a évalué à 97 milliards d’euros l’impact économique de la pollution en France. A quelques semaines de la conférence COP 21, la qualité de l’air est plus que jamais un enjeu sensible.

Mais le sujet est extrêmement complexe. C’est un phénomène invisible dont on ne perçoit pas les évolutions, ses sources sont nombreuses et variées et interagissent les unes avec les autres. Comment chaque individu peut-il faire pour s’en protéger et éviter d’aggraver le phénomène ? C’est la mission que s’est fixée Plume Labs : donner aux citoyens des réponses concrètes, apportées par les données.

Il existe plusieurs grandes familles de polluants réglementés. Le dioxyde d’azote, qui donne une lueur brun-rouge à l’air, est émis dans le cadre de combustions imparfaites (transports, voiture). Il est très local car il réagit et se décompose vite. Les particules fines voyagent plus. Ce sont des amas solides de quelques dizaines de micromètres jusqu’à une centaine de nanomètres. Elles se composent de métaux, silices, produits organiques, sels marins… Plus une particule est fine, plus elle pénètre profondément dans le corps. L’ozone est très oxydant et nocif pour les voies respiratoires. On le trouve surtout dans les parcs et jardins car il réagit avec d’autres composés issus de la circulation automobile.

Comment prédire la pollution ?

Une étude du phénomène montre son extrême variabilité géographique, avec des niveaux pouvant varier du simple au quintuple. La variabilité temporelle est très importante aussi, avec typiquement des pics de pollution le matin et l’après-midi et des pics plus faibles le weekend. Aussi quand on cherche à faire la prévision de pollution la plus simple possible, avec une semaine moyenne, on reste assez loin de la réalité, car les signaux varient très fortement autour de cette moyenne.

On pourrait aussi envisager le phénomène de pollution comme une série temporelle, mais il existe tellement de phénomènes physiques, humains et météo à l’œuvre que l’on aura toujours du mal à faire des prévisions de bonne qualité avec cette unique approche. S’il y a beaucoup de domaines où le machine learning surpasse l’état de l’art du domaine, dans le cas de la prévision de la pollution ce n’est pas le cas et il est nécessaire d’utiliser les algorithmes en conjonction avec les modèles physiques atmosphérique classiques afin d’avoir de bons résultats.

Les données dont on dispose pour élaborer ces modèles ont quatre origines.

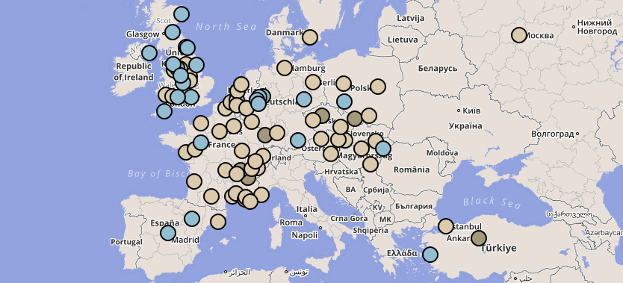

- Mesures in situ, en provenance de stations de mesure. Il en existe une quinzaine à Paris, en haut des toits de bâtiments. Elles sont précises et coûteuses mais ne capturent pas la variabilité du phénomène dans les bâtiments, dans le métro…

- Mesures ex situ, réalisées à distance par satellite, et mises Mise à disposition par la NASA par exemple.

- Grilles d’émissions de gaz (comme le dioxyde de soufre) attendues en moyenne sur l’année, qui sont aussi un reflet de l’activité économique du globe.

- Conditions atmosphériques (humidité, température, vent…)

Des données, mais quelles données ?

Mais comment accéder à et récupérer ces données ? Quelle est leur qualité réelle ? L’accessibilité est très variable, certains pays mettent leurs données à disposition, d’autre ne le font pas. C’est souvent un sujet de tensions géopolitiques ou économiques. Il peut suffire aussi qu’une ville déplace une station 100 mètres plus loin d’un axe routier pour fausser les relevés…

Le format des données est aussi une vraie difficulté car rien n’est harmonisé. Certains chiffres sont publiés sous forme d’images ou insérés dans du JavaScript. Il y a aussi les problèmes d’indice, de non standardisation des chiffres. Enfin il faut savoir distinguer un bug technique dû à une panne d’un phénomène réel mais inhabituel comme des feux d’artifice ou un incendie. Il est alors intéressant de comparer prévisions des algorithmes et données collectées.

Les propositions de Plume Labs

Plume Air Report est une application mobile grand public. Elle est destinée à faire connaitre les travaux de Plume Labs et leurs applications pratiques. Elle propose une information en temps réel sur la pollution et surtout des prévisions de pollution, qui permettent de choisir le meilleur moment pour faire son jogging ou prendre les transports en commun plutôt que sa voiture…

Mais la prochaine étape de la start-up est la mise sur le marché d’un capteur individuel, qui permettra d’aller vers des mesures beaucoup plus personnelles, avec un maillage plus fin du territoire. Ces capteurs seront une source de données complémentaire des réseaux de capteurs lourds et coûteux. Ils représentent un énorme défi en termes de matériel miniaturisé aussi bien que de machine learning.

Le développement futur de Plume Labs se fera sur un marché international, comprenant la Chine, l’Inde et l’Amérique du nord, des pays dont les enjeux en termes de pollution sont très lourds et dont les populations sont déjà très sensibilisées.

En savoir plus : www.plumelabs.com